Blog

Når konsulenthusets kæde springer af

Hvordan kategoriserer vi didaktiske, digitale læremidler? Det kan lyde som et akademisk spørgsmål. Men det er et vigtigt spørgsmål, fordi det har politiske konsekvenser, når vi bruger kategoriseringen til at afdække effekter, som danner grundlag for fremtidige prioriteringer af læremidler i folkeskolen. I 2014 udkom Rambølls rapport med en sådan kategorisering af læremidler – i vores optik en rapport, der på et uklart grundlag kommer frem til en del forkerte resultater og drager problematiske konklusioner. Læremiddel.dk og Center for Anvendt Skoleforskning har nu gennemført en tilsvarende undersøgelse, der skærer kagen anderledes og kommer frem til ganske andre resultater.

Foto: Colourbox.dk / Fotograf: Knud Erik Christensen

Af Keld Skovmand, Stig Toke Gissel og Thomas Illum Hansen

Baggrund

Med indsatsen for øget anvendelse af it i folkeskolen blev der investeret et milliardstort beløb i digitalisering af folkeskolen. Indsatsen var del af den fællesoffentlige digitaliseringsstrategi for 2011-2015, som blev forlænget til 2017. Rambøll gennemførte forud for indsatsen en kategorisering af digitale læremidler, som blev offentliggjort med rapporten Anvendelse af digitale læremidler. Effektmåling (2014).

Omdrejningspunktet i undersøgelsen var en effektmåling af digitale læremidler, fordi en stor del af de mange ressourcer blev investeret i en støttepulje, der boostede markedet for digitale læremidler via et statstilskud på 50 % af indkøbsprisen. Rambølls måling tjente flere formål. Dels skulle den være med til at dokumentere de positive effekter af digitale læremidler og hermed legitimere den store indsats. Dels skulle den tjene som en førmåling, der kunne danne grundlag for en slutevaluering af den samlede effekt af investeringen.

Et centralt element i 2014-rapporten var:

En typologisering af didaktiske digitale læremidler som værende enten repetitive, formidlende, stilladserende eller praksisstilladserende. Undersøgelsen søger bl.a. at analysere, hvorvidt disse typer af digitale læremidler har forskellige effekter.

(Rambøll, 2014, s. 1)

Typologiseringen af de digitale læremidler stammer fra en rapport, som Thomas Illum Hansen og Jeppe Bundsgaard lavede i 2013. Vi anvender også fire kategorier, der læner sig op ad Illum Hansen & Bundsgaards, som vi i to tilfælde har ændret (se nedenfor).

I Læremiddel.dk og Center for Anvendt Skoleforskning har vi valgt at komme med vores forslag til, hvordan en kategorisering af didaktiske, digitale læremidler skal gennemføres. Det har vi gjort, fordi vi finder, at Rambølls kategorisering er både mangelfuld, misvisende og uigennemsigtig. Det vil vi vise i det følgende.

Fire problemer med Rambølls kategorisering

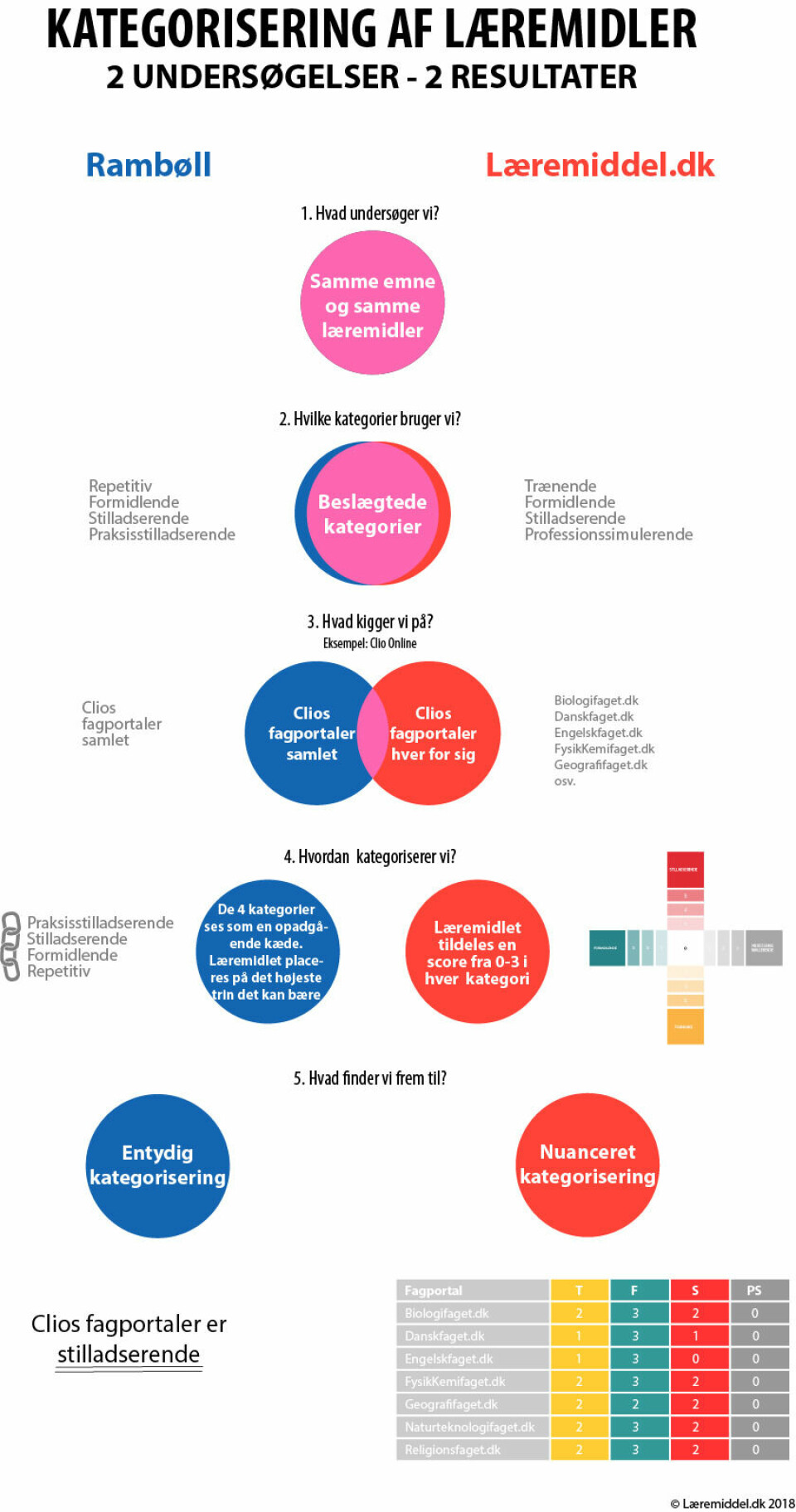

I vores undersøgelse når vi til ganske andre resultater end Rambøll, selv om vi analyserer en tilnærmelsesvis identisk samling af læremidler med afsæt i stort set enslydende kategorier. Og hvorfor gør vi så det? Det vil vi illustrere ved at påpege fire problemer ved Rambølls undersøgelse og komme med alternative løsninger, der afhjælper dens metodiske mangler.

Problem 1: Unuanceret kategorisering

Rambølls tilgang indebærer en kategorisering af det enkelte læremiddel i én af deres fire kategorier. Kategoriseringen ”løfter et givent læremiddel så højt op i kæden, som midlet kan bære” (Rambøll, 2014, Bilag 1, side 9). Dette medfører et metodisk problem, idet kategoriseringen baseres på en enten-eller-logik og dermed ikke giver et nuanceret billede af læremidlerne, der ofte blander træk fra de fire kategorier. Rapporten indfanger derfor ikke, hvilke didaktiske træk et læremiddel i øvrigt har. Indeholder et læremiddel, der er kategoriseret som stilladserende, også trænende og formidlende træk? Eller er det kun stilladserende?

I vores rapport operationaliserer vi de fire kategorier, vi arbejder med (trænende, formidlende, stilladserende og professionssimulerende) i seks parametre, og ud fra disse parametre scorer vi det didaktiske potentiale i læremidlet på en skala fra 0 til 3 for hver kategori. Dette muliggør en nuanceret scoring af læremidlernes didaktiske potentiale i forhold til alle fire kategorier. Et vigtigt resultat af disse analyser er, at vi identificerer en kompleksitet i mange af de scorede læremidler, som indebærer, at en entydig kategorisering af dem er misvisende. Didaktiske, digitale læremidler er ofte ikke enten trænende, formidlende, stilladserende eller professionssimulerende. Vores undersøgelse viser, at kun ca. en tredjedel af læremidlerne kan kategoriseres entydigt, og at langt den overvejende del af disse er trænende. Analyserne viser også, at der ikke er en entydig systematik i tilstedeværelsen af de fire kategorier i læremidlerne. Rambølls billede af de fire kategorier som en kæde holder ikke.

Problem 2: Entydig kategorisering

Rambøll anskuer meget omfattende og, viser vi, forskelligartede læremidler under ét. Fx kategoriserer Rambøll Clio Onlines og Gyldendals fagportaler samlet. I vores undersøgelse analyserer vi disse fagportaler hver for sig. Således viser vi i rapporten scorerne for de enkelte fagportaler og beregner en gennemsnitlig score, som vi anvender, når vi skal give en fagportal én samlet score. Vi viser, at en entydig kategorisering af disse samlinger af portaler ikke giver megen mening, da der er høj diversitet mellem delene. Fx kategoriserer Rambøll Clio Online som stilladserende, men ingen af de specifikke fagportaler er rent stilladserende, og ingen af dem har træk fra den stilladserende kategori som det dominerende. Ni ud af ti af Clios fagportaler udviser dominerende formidlende træk (scorer 3), men har oftest også trænende og stilladsende træk. Clio Online består således af læremidler, der blander træk fra tre kategorier.

Problem 3: Upræcise kriterier

Rambøll præciserer ikke kriterierne for, hvornår et læremiddel kategoriseres som det ene eller andet. Rambøll angiver selv, at et givet læremiddel kategoriseres som stilladserende (niveau tre af fire i kæden af kategorier), fordi der i læremidlet er ”mange opgaver af stilladserende karakter” (Rambøll, 2014, Bilag 1, s. 9). Hvor mange opgaver er mange? Hvad kigger man efter i forhold til at identificere opgaver af stilladserende karakter? Og hvor i et meget omfangsrigt læremiddel (fx Clio Onlines samlede række af fagportaler) har man kigget for at komme frem til denne kategorisering? Det giver Rambøll ikke noget svar på.

Med vores parametre viser vi tydeligt, hvad vi konkret kigger efter, når vi kategoriserer. Vores didaktiske parametre omfatter læremidlets pædagogiske præmis, målorientering og progression, dets strukturering af arbejdsproces og organisering af deltagerne, rammesætning af aktiviteter og tildeling af elevroller samt hvordan det faciliterer læring. Scoren 0-3 fremkommer ved, at vi vurderer det enkelte læremiddel ud fra de seks parametre, som vi operationaliserer som kontrolspørgsmål til hver kategori. Bonner læremidlet fx ud på to af spørgsmålene inden for en kategori, opnår det scoren 1. Med andre ord anvender vi en række didaktiske kategorier som grundlag for at kategorisere didaktiske, digitale læremidler.

Problem 4: Manglende transparens

Den forskningsproces og -metode, der ligger til grund for Rambøll-rapporten, er uigennemskuelig og utilgængelig for efterprøvning. Rambøll fremlægger hverken sit datasæt eller metode, og denne manglende transparens i forhold til både datagrundlag og analyseproces forhindrer andre i at efterprøve resultaterne.

I modsætning til Rambøll fremlægger vi vores datasæt, så alle kan gå vores resultater efter og se vores delresultater. Ydermere ekspliciterer vi i rapporten vores færd gennem hvert læremiddel, så alle kan se, hvad der rent empirisk ligger til grund for vores kategoriseringer.

Kæden er knækket

Disse problemer ved Rambølls rapport betyder, at undersøgelsen mangler både reliabilitet, validitet og gentagelighed – de tre kriterier, man vurderer kvaliteten af videnskabeligt arbejde på. Rambølls resultater kan ikke efterprøves gennem gentagelse, fordi de hverken fremlægger datasæt eller tydeliggør deres empiriske grundlag. Validiteten afhænger af, om kategoriseringen og måden, den bruges på, er solid og dækkende nok til at give retvisende resultater.

Rimelig kritik?

Man kan spørge sig selv, om det er rimeligt, at Læremiddel.dk og Center for Anvendt Skoleforskning, som har forsknings- og ekspertviden om netop læremidler, på denne måde kritiserer andres arbejde. Vi har valgt at gøre det af en række grunde, hvoraf vi vil fremhæve to. For det første har vi valgt selv at investere i denne undersøgelse, da det er os magtpåliggende at demonstrere værdien af læremiddelforskning som led i en milliardinvestering. Det har undret os, at forskning i digitale læremidler ikke har spillet en større rolle i forbindelse med så massiv en investering. For det andet er vi af den overbevisning, at rapporter, der skal danne grundlag for vigtige politiske beslutninger, bør være retvisende, gennemarbejdede og basere sig på en nuanceret afdækning og forståelse af det emne, de omhandler. Det ser vi ikke i dette tilfælde. I stedet for at undersøge, hvilke konkrete virkninger læremidlerne har i praksis, hvordan, for hvem og under hvilke omstændigheder, har Rambøll valgt at måle effekt gennem selvrapportering, dvs. at man har spurgt lærere og ledere om en række ting, og omsat resultaterne til effektstørrelser.

Vi kan også stille spørgsmålet om, hvorvidt man kan vurdere effekten af inddragelse af digitale læremidler i folkeskolen ud fra en så problematisk kategorisering.

Hvis man accepterer vores konklusion, at grundlaget for 2014-rapporten er forkert, så bliver det vanskeligt at gennemføre en samlet evaluering af investeringen i digitale læremidler. Er det på sådan et grundlag, vi skal basere beslutninger om fremtidige prioriteringer i forhold til læremidler i folkeskolen?

Du kan læse rapporten om undersøgelsen, som er igangsat af Thomas Illum Hansen og Jeppe Bundsgaard og udarbejdet af Stig Toke Gissel og Keld Skovmand, i sin helhed her:

http://laeremiddel.dk/viden-og-vaerktoejer/rapporter/kategorisering-af-digitale-laeremidler/

Her ligger også datasættet fra undersøgelsen.

Litteratur

Hansen, T. I. & Bundsgaard, J. (2013). Kvaliteter ved digitale læremidler og ved pædagogiske praksisser med digitale læremidler: forskningsbaseret bidrag til anbefalinger, pejlermærker og kriterier i forbindelse med udmøntning af midler til indkøb af digitale læremidler. Ministeriet for Børn og Undervisning. Lokaliseret [den 30.04.2018] på: https://www.uvm.dk/-/media/filer/uvm/udd/folke/pdf13/sep/130927-forskningsrapport-effektmaaling.pdf

Rambøll (2014). Anvendelse af digitale læremidler. Effektmåling. Lokaliseret [den 04.05.18] på: https://www.uvm.dk/folkeskolen/laering-og-laeringsmiljoe/it-i-undervisningen/initiativer-2012-2016/effekten-af-digitale-laeremidler