Jeppe Bundsgaard

Blog

Nye resultatvisninger i nationale test

Ministeriet har lyttet til kritikken af nationale test og har svaret ved at give lærerne langt flere og mere relevante oplysninger om elevernes besvarelser. Det er rigtig godt. Og det gør det nok endnu mere tydeligt for den enkelte lærer hvor mange kilo gran salt man skal tage resultaterne med.

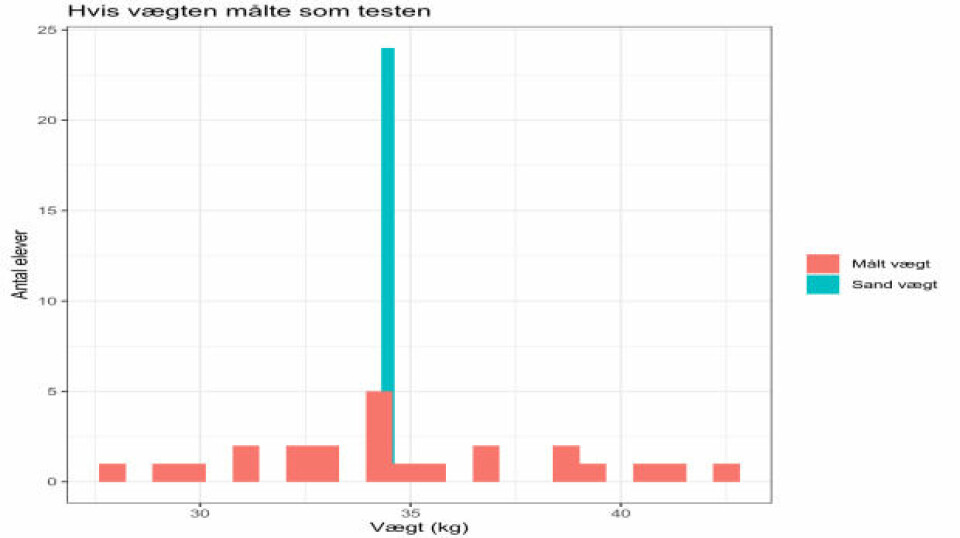

Siden Jørgen Damgaard fra Norddjurs i 2014 viste hvordan hans elever scorede helt forskelligt i to tests med tre dages mellemrum og Marina Norling i 2016 illustrerede problemerne i en længere serie om nationale test, er det blevet stadig mere klart hvor galt det står til med sikkerheden i resultaterne fra nationale test (se også mit forsøg på at illustrere problemerne).

Nu har ministeriet givet resultatvisningerne en kraftig overhaling, så den enkelte lærer får langt flere og langt mere relevante oplysninger om sine elevers resultater. Visningerne er forklaret i en kort vejledning til lærere i alle fag. Det forklares fx at læreren undervejs i testen kan se på sin skærm hvis en elev er meget hurtig (”det kan skyldes gætteri”) eller meget langsom. Læreren kan så henvende sig til eleven og give eleven en pause eller tale med denne om hvad problemet er. I vejledningen kaldes dette ”et uhensigtsmæssigt testforløb” fordi det kan føre til at resultatet ikke bliver et udtryk for elevens faktiske dygtighed. Det giver god mening. Og faktisk kan man statistisk efter en gennemført test udregne det man kalder ”person fit” som er et udtryk for hvor forventet elevens besvarelser er (fx vil en elev der svarer rigtigt på svære opgaver og forkert på lette opgaver, få et lavt person fit). Det ville være en god oplysning at give lærere, elever og forældre (for resultater med lavt person fit kan man ikke fæste lid til), men det gør man ikke på nuværende tidspunkt. Opfordringen er hermed givet videre.

Tilbage til hvad man faktisk gør. Når testen er gennemført, kan man få et samlet overblik over hvor lang tid den enkelte elev har brugt på testens opgaver inden for det enkelte profilområde. Og man kan for hver enkelt opgave se hvordan dette forholder sig til den tid der normalt anvendes på opgaven. Spørgsmålet er selvfølgelig hvordan man skal tolke den oplysning. Hvad betyder det at en elev har været længe om nogle opgaver – måske om alle opgaver? At hun har taget testen alvorligt? At hun er langsomtopfattende? At hun ikke læser så godt? At hun var lidt træt? At hun lavede alt muligt andet end at løse opgaverne? … og hvad skal læreren efterfølgende bruge den oplysning til?

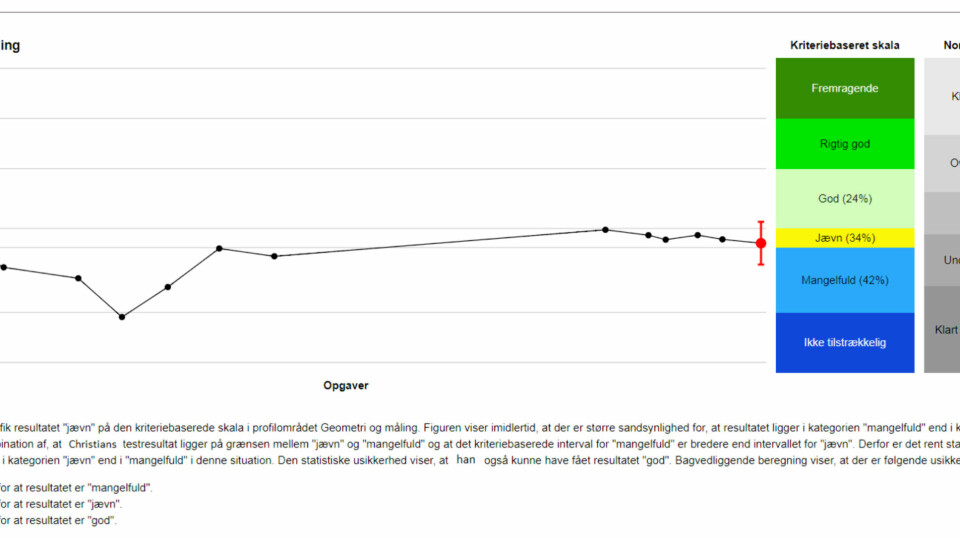

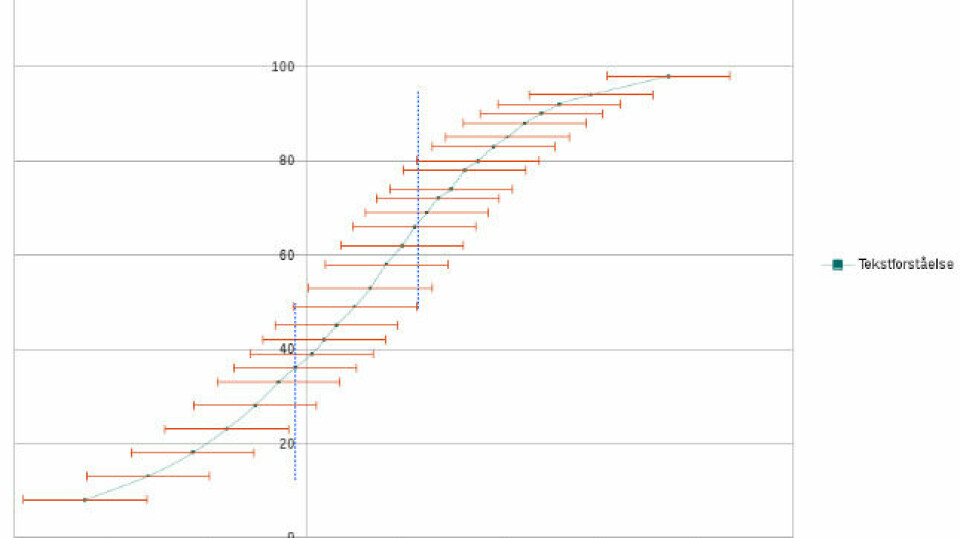

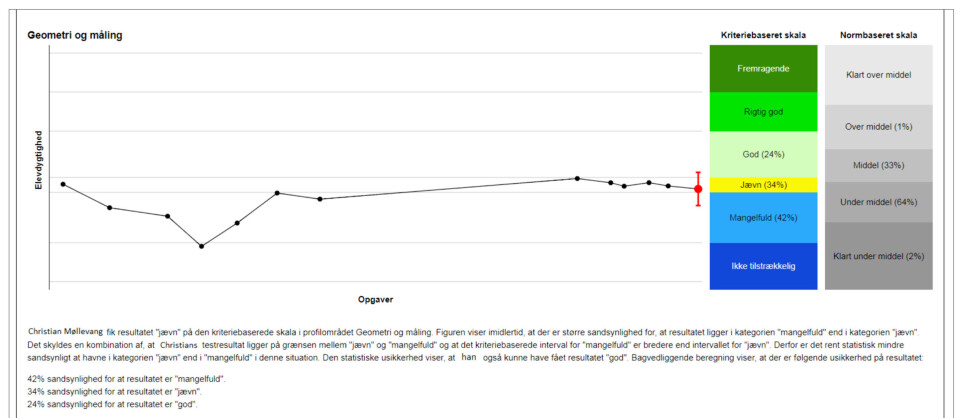

Usikkerheden vises nu endelig

Den anden nyskabelse handler om usikkerhed på resultatet. Hidtil har man jo blot fået et tal på en skala fra 1-100 (eller en besked om placering i en gruppe (kriteriebaseret eller normbaseret)). Men nu får man også besked om hvor stor usikkerheden på resultatet er med en fin angivelse af hvilket forløb eleven har haft i sine besvarelser. Det markeres med en rød streg (se figur). Ministeriet skriver ”Denne røde lodrette streg betyder således, at elevens resultat ligger inden for dette interval”. Men det er ikke helt korrekt. Den lodrette streg udgør det man kalder et 68 procent-konfidensinterval, hvilket vil sige at elevens resultat med 68 procents sandsynlighed ligger inden for dette interval (det fremgår ikke af vejledningen, men jeg har spurgt ministeriet og dette var deres svar).

Knap 1 ud af 3 elever vil således ligge uden for dette interval. Den lader vi lige stå et øjeblik...

Normalt ville man opgive et 95 procent-konfidensinterval – så kun 1 ud af 20 ville ligge uden for intervallet. For at få et 95 procent-konfidensinterval skal man gange 68 procent-konfidensintervallet med 1,96 – det vil med andre ord være knap dobbelt så stort som det ministeriet har valgt at angive. Sjovt nok er de procenttal der vises i de kriteriebaserede scorer, beregnet på baggrund af 95 procent-konfidensintervallet. Så i eksemplet har eleven altså større sandsynlighed (42 procent) for faktisk at ligge i ”Mangelfuld” end i ”Jævn” (34 procent).

Baggrunden for brug af konidensintervaller er fx forklaret her og her og her.

Men okay – uanset hvad kan man vist roligt sige at elevens resultat er forbundet med pænt stor usikkerhed – ganske som Jørgen Damgaard og Maria Norling viste i 2014 og 2016. Mit håb er at det nu vil stå lysende klart for alle lærere, at de ikke kan fæste nogen lid til de konkrete resultater for den enkelte elev. Der er med andre ord IKKE NOGET AT BRUGE NATIONALE TEST TIL PÆDAGOGISK, DIDAKTISK ELLER PÅ NOGEN ANDEN MÅDE for læreren!

Der er det forunderlige med statistik at når man får flere datapunkter, så bliver man mere sikker på resultatet. Og dette betyder at på klasse- og skoleniveau er resultaterne væsentligt mindre usikre. Og på kommuneniveau er de ret sikre. Så skolelederen og den skolechefen kan fortsat bruge disse resultater til at vurdere hvor gode eleverne er til nationale test samlet set. Måske tror de at de derfra kan slutte hvor gode lærerne er, men hvis de gør det, tager de grueligt fejl. Nationale test tester nemlig fortsat noget meget teknisk og derfor noget helt andet end folkeskolelovens formålsparagraf foreskriver, noget helt andet skolereformen hævder at ville fremme, og noget helt andet end der står i Fælles Mål (på nær i nogle få meget tekniske målpar).

Hvornår begynder de ansvarlige i kommunerne at tage disse problemer alvorligt? Så længe de stoler på dette meget ringe instrument, så handler de på baggrund af skæve tal.

* Disclaimer: Jeg er ikke imod tests. Jeg er imod dårlige tests som tester noget forkert.